Bien sûr, votre assistant IA peut prendre rendez-vous pour vous, mais qu'en est-il de toute conversation significative? Shutterstock / Bas Nastassia

Bien sûr, votre assistant IA peut prendre rendez-vous pour vous, mais qu'en est-il de toute conversation significative? Shutterstock / Bas Nastassia

Google récemment dévoilé sa dernière IA parlante, appelée Duplex. Duplex sonne comme une vraie personne, avec des pauses, "umms" et "ahhs".

Le géant de la technologie dit qu'il peut parler aux gens au téléphone pour prendre rendez-vous et vérifier les heures d'ouverture de l'entreprise.

Dans les conversations enregistrées qui ont été jouées lors du dévoilement de Google, il a conversé de manière transparente avec les humains du côté récepteur, qui semblaient totalement inconscients qu'ils ne parlaient pas avec une autre personne.

Ces appels ont quitté le public axé sur la technologie au Google show haletant et applaudissant. Dans un exemple, l'IA a même compris quand la personne à qui elle parlait s'est mélangée et a pu continuer à suivre la conversation et répondre de manière appropriée quand on lui a dit qu'elle n'avait pas besoin de faire une réservation.

La montée des assistants IA

Si vous avez utilisé l'un des assistants vocaux actuellement disponibles, tels que Google Home, Siri d'Apple ou Amazon Echo, cette flexibilité pourrait vous surprendre. Ces assistants sont notoirement difficile à utiliser pour autre chose que les demandes standard telles que téléphoner à un contact, jouer une chanson, faire une simple recherche sur le Web ou définir un rappel.

Lorsque nous parlons à ces assistants de la génération actuelle, nous sommes toujours conscients que nous parlons à une IA et nous adaptons souvent ce que nous disons en conséquence, d'une manière que nous espérons maximiser nos chances de le faire fonctionner.

Mais les gens qui parlaient à Duplex n'en avaient aucune idée. Ils ont hésité, ont fait marche arrière, ont sauté des mots et ont même changé les faits à mi-chemin d'une phrase. Duplex n'a rien raté. Il semblait vraiment comprendre ce qui se passait.

Lire la suite: Les haut-parleurs intelligents pourraient être le point de basculement de la domotique

L'avenir est-il donc arrivé plus tôt que prévu? Le monde est-il sur le point d'être rempli d'assistants IA en ligne (et par téléphone) qui discutent joyeusement et font tout pour nous? Ou pire, serons-nous soudainement entourés d'IA intelligentes avec leurs propres pensées et idées qui peuvent ou non nous inclure les humains?

La réponse est définitivement «non». Pour comprendre pourquoi, il est utile de jeter un coup d'œil sous le capot sur ce qui motive une IA telle que celle-ci.

Duplex: comment ça marche

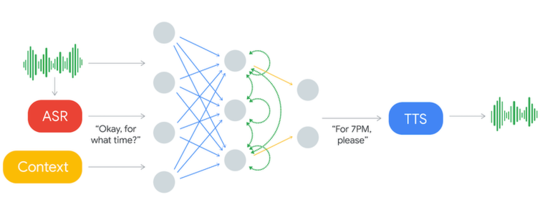

C'est ce que Système AI duplex ressemble à.

Le son entrant est traité via un système ASR. Cela produit du texte qui est analysé avec des données de contexte et d'autres entrées pour produire un texte de réponse qui est lu à haute voix via le système de synthèse vocale (TTS). Google

Le son entrant est traité via un système ASR. Cela produit du texte qui est analysé avec des données de contexte et d'autres entrées pour produire un texte de réponse qui est lu à haute voix via le système de synthèse vocale (TTS). Google

Le système prend une «entrée» (indiquée à gauche) qui est la voix de la personne à qui elle parle au téléphone. La voix passe par la reconnaissance automatique de la parole (ASR) et est convertie en texte (mots écrits). L'ASR est lui-même un système d'IA avancé, mais d'un type qui est déjà couramment utilisé dans les assistants vocaux existants.

Le texte est ensuite scanné pour déterminer le type de phrase qu'il s'agit (comme un message d'accueil, une déclaration, une question ou une instruction) et extraire toute information importante. Les informations clés deviennent alors une partie du contexte, qui est une entrée supplémentaire qui maintient le système à jour avec ce qui a été dit jusqu'à présent dans la conversation.

Le texte de l'ASR et du contexte est ensuite envoyé au cœur de Duplex, appelé réseau de neurones artificiels (ANN).

Dans le diagramme ci-dessus, l'ANN est indiqué par les cercles et les lignes qui les relient. Les RNA sont calqués sur notre cerveau, qui ont des milliards de neurones connectés entre eux dans d'énormes réseaux.

Pas tout à fait un cerveau, pourtant

Les ANN sont cependant beaucoup plus simples que notre cerveau. La seule chose que celui-ci essaie de faire est de faire correspondre les mots d'entrée avec une réponse appropriée. L'ANN apprend en se voyant montrer les transcriptions de milliers de conversations de personnes faisant des réservations pour des restaurants.

Avec suffisamment d'exemples, il apprend quels types de phrases d'entrée à attendre de la personne à qui il parle et quels types de réponses donner à chacun.

La réponse textuelle générée par l'ANN est ensuite envoyée à un synthétiseur de synthèse vocale (TTS), qui la convertit en mots prononcés qui sont ensuite lus à la personne au téléphone.

Encore une fois, ce synthétiseur TTS est une IA avancée - dans ce cas, il est plus avancé que celui de votre téléphone, car il semble presque impossible à distinguer de toute voix normale.

C'est tout ce qu'on peut en dire. Bien qu'il soit à la pointe de la technologie, le cœur du système n'est vraiment qu'un processus de correspondance de texte. Mais vous pourriez vous demander - si c'est si simple, pourquoi ne pourrions-nous pas le faire avant?

Une réponse apprise

Le fait est que le langage humain, et la plupart des autres choses dans le monde réel, sont trop variables et désordonnés pour être bien gérés par les ordinateurs normaux, mais ce genre de problème est parfait pour l'IA.

Notez que la sortie produite par l'IA dépend entièrement des conversations qui lui ont été montrées pendant son apprentissage.

Cela signifie que différentes IA doivent être formées pour effectuer des réservations de différents types - ainsi, par exemple, une IA peut réserver des restaurants et une autre peut réserver des rendez-vous capillaires.

Cela est nécessaire car les types de questions et de réponses peuvent varier considérablement pour différents types de réservations. C'est aussi comment Duplex peut être bien meilleur que les assistants vocaux généraux, qui doivent gérer de nombreux types de demandes.

Alors maintenant, il devrait être évident que nous n'allons pas avoir de conversations informelles avec nos assistants IA de si tôt. En fait, toutes nos IA actuelles ne sont en fait rien de plus que des modèles de correspondance (dans ce cas, des modèles de texte correspondants). Ils ne comprennent pas ce qu'ils entendent, ce qu'ils regardent ou ce qu'ils disent.

La correspondance des motifs est une chose que notre cerveau fait, mais il en fait beaucoup plus. La clé pour créer une IA plus puissante peut être de débloquer plus de secrets du cerveau. Le voulons-nous? Eh bien, c'est une autre question.![]()

A propos de l'auteur

Peter Stratton, chercheur postdoctoral, L'Université du Queensland

Cet article est republié de The Conversation sous une licence Creative Commons. Lis le article original.