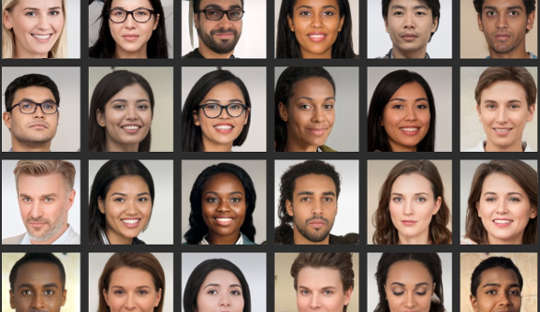

Même si vous pensez que vous êtes doué pour analyser les visages, recherche montre de nombreuses personnes ne peuvent pas faire la distinction de manière fiable entre les photos de vrais visages et les images générées par ordinateur. Ceci est particulièrement problématique maintenant que les systèmes informatiques peuvent créer des photos réalistes de personnes qui n'existent pas.

Récemment, un faux profil LinkedIn avec une photo de profil générée par ordinateur a fait la une des journaux parce qu'il connecté avec succès avec des responsables américains et d'autres personnes influentes sur la plate-forme de mise en réseau, par exemple. Les experts du contre-espionnage disent même que les espions créent régulièrement des profils fantômes avec de telles images pour ciblez des cibles étrangères sur les réseaux sociaux.

Ces contrefaçons profondes se généralisent dans la culture quotidienne, ce qui signifie que les gens devraient être plus conscients de la façon dont ils sont utilisés dans le marketing, la publicité et les médias sociaux. Les images sont également utilisées à des fins malveillantes, telles que la propagande politique, l'espionnage et la guerre de l'information.

Leur fabrication implique quelque chose appelé un réseau neuronal profond, un système informatique qui imite la façon dont le cerveau apprend. Celui-ci est "formé" en l'exposant à des ensembles de données de visages réels de plus en plus volumineux.

En fait, deux réseaux de neurones profonds s'affrontent, rivalisant pour produire les images les plus réalistes. En conséquence, les produits finaux sont surnommés images GAN, où GAN signifie Generative Adversarial Networks. Le processus génère de nouvelles images statistiquement indiscernables des images d'apprentissage.

Dans notre étude publiée dans iScience, nous avons montré que le fait de ne pas distinguer ces visages artificiels de la réalité a des implications sur notre comportement en ligne. Nos recherches suggèrent que les fausses images peuvent éroder notre confiance envers les autres et modifier profondément notre façon de communiquer en ligne.

Mes collègues et moi avons découvert que les gens percevaient les visages du GAN comme étant encore plus réalistes que les photos authentiques de visages de personnes réelles. Bien qu'il ne soit pas encore clair pourquoi c'est, cette découverte ne mettre en évidence les avancées récentes de la technologie utilisé pour générer des images artificielles.

Et nous avons également trouvé un lien intéressant avec l'attractivité : les visages jugés moins attrayants étaient également jugés plus réels. Les visages moins attrayants pourraient être considérés comme plus typiques et le visage typique peut être utilisé comme référence par rapport auquel tous les visages sont évalués. Par conséquent, ces visages GAN auraient l'air plus réels car ils ressemblent davantage aux modèles mentaux que les gens ont construits à partir de la vie quotidienne.

Mais considérer ces visages artificiels comme authentiques peut également avoir des conséquences sur les niveaux généraux de confiance que nous accordons à un cercle de personnes inconnues - un concept connu sous le nom de "confiance sociale".

Nous lisons souvent trop dans les visages que nous voyons, et le les premières impressions que nous formons guident nos interactions sociales. Dans une deuxième expérience qui faisait partie de notre dernière étude, nous avons vu que les gens étaient plus susceptibles de faire confiance aux informations véhiculées par des visages qu'ils avaient précédemment jugés réels, même s'ils étaient générés artificiellement.

Il n'est pas surprenant que les gens accordent plus de confiance aux visages qu'ils croient être réels. Mais nous avons constaté que la confiance était érodée une fois que les gens étaient informés de la présence potentielle de visages artificiels dans les interactions en ligne. Ils ont ensuite montré des niveaux de confiance inférieurs, dans l'ensemble, que les visages soient réels ou non.

Ce résultat pourrait être considéré comme utile à certains égards, car il a rendu les gens plus méfiants dans un environnement où de faux utilisateurs peuvent opérer. D'un autre point de vue, cependant, cela peut progressivement éroder la nature même de notre façon de communiquer.

En général, nous avons tendance à opérer une hypothèse par défaut selon laquelle les autres personnes sont fondamentalement véridiques et dignes de confiance. La croissance des faux profils et autres contenus en ligne artificiels soulève la question de savoir dans quelle mesure leur présence et nos connaissances à leur sujet peuvent modifier cet état de « vérité par défaut », érodant finalement la confiance sociale.

Changer nos valeurs par défaut

La transition vers un monde où ce qui est réel est indiscernable de ce qui ne l'est pas pourrait également faire passer le paysage culturel d'être principalement véridique à être principalement artificiel et trompeur.

Si nous remettons régulièrement en question la véracité de ce que nous vivons en ligne, cela pourrait nous obliger à redéployer notre effort mental du traitement des messages eux-mêmes au traitement de l'identité du messager. En d'autres termes, l'utilisation généralisée de contenus en ligne hautement réalistes, mais artificiels, pourrait nous obliger à penser différemment – d'une manière à laquelle nous ne nous attendions pas.

En psychologie, nous utilisons un terme appelé « surveillance de la réalité » pour déterminer comment nous identifions correctement si quelque chose vient du monde extérieur ou de l'intérieur de notre cerveau. L'avancée des technologies qui peuvent produire des visages, des images et des appels vidéo faux, mais très réalistes, signifie que la surveillance de la réalité doit être basée sur des informations autres que nos propres jugements. Cela appelle également à une discussion plus large sur la question de savoir si l'humanité peut encore se permettre de faire défaut à la vérité.

Il est crucial que les gens soient plus critiques lors de l'évaluation des visages numériques. Cela peut inclure l'utilisation de recherches d'images inversées pour vérifier si les photos sont authentiques, se méfier des profils de médias sociaux contenant peu d'informations personnelles ou un grand nombre d'abonnés, et être conscient du potentiel d'utilisation de la technologie deepfake à des fins néfastes.

La prochaine frontière dans ce domaine devrait être l'amélioration des algorithmes de détection des faux visages numériques. Ceux-ci pourraient ensuite être intégrés dans les plateformes de médias sociaux pour nous aider à distinguer le vrai du faux en ce qui concerne les visages des nouvelles connexions.

A propos de l'auteur

Manos Tsakiris, professeur de psychologie, directeur du Centre pour la politique des sentiments, Royal Holloway University of London

Cet article est republié de The Conversation sous une licence Creative Commons. Lis le article original.