Il n'est pas clair si la campagne anti-fausse de la Malaisie est soutenue par la science du comportement aussi. Photo AP / Vincent Thian

Le PDG de Facebook, Mark Zuckerberg récemment reconnu la responsabilité de son entreprise en aidant à créer l'énorme quantité de fausses nouvelles qui ont tourmenté l'élection 2016 - après dénis antérieurs. Pourtant, il n'a pas donné de détails concrets sur ce que Facebook pouvait faire à ce sujet.

Heureusement, il existe un moyen de lutter contre les fausses nouvelles qui existent déjà et a la science du comportement de son côté: le Engagement pro-vérité .

I faisait partie d'une équipe de scientifiques du comportement qui a eu l'idée d'un engagement comme un moyen de limiter la propagation de la désinformation en ligne. Deux études qui ont essayé d'évaluer son efficacité suggèrent que cela fonctionne réellement.

Lutte contre de fausses nouvelles

Un nombre croissant de législateurs américains et de citoyens ordinaires pensent que les entreprises de médias sociaux comme Facebook et Twitter doivent faire plus pour lutter contre la diffusion de fausses nouvelles - même si cela entraîne une censure.

A enquête récente, par exemple, a montré que 56 pour cent des répondants disent que les entreprises technologiques "devraient prendre des mesures pour restreindre les fausses informations en ligne, même si cela limite la liberté d'information."

Mais quelles mesures ils pourraient prendre - à court de censure et de contrôle du gouvernement - est une grande question.

Avant de répondre à cette question, examinons comment les fausses nouvelles se propagent. Dans les élections 2016, par exemple, nous avons appris qu'un beaucoup de désinformation était le résultat de robots russes faussetés utilisées essayer d'exacerber les divisions religieuses et politiques américaines.

Pourtant, les messages publiés par les robots ne signifieraient pas grand-chose à moins que des millions d'utilisateurs réguliers des médias sociaux choisissent de partager l'information. Et il se trouve des gens ordinaires répandre la désinformation sur les médias sociaux beaucoup plus vite et plus loin que les histoires vraies.

En partie, ce problème provient de personnes partageant des histoires sans les lire. Ils ne savaient pas qu'ils propageaient des faussetés.

Cependant, 14 pour cent des Américains interrogés dans un Sondage 2016 rapporté partager sciemment de fausses nouvelles. Cela peut être parce que la recherche montre que les gens sont plus susceptibles pour tromper les autres quand ça profite leur parti politique ou un autre groupe auquel ils appartiennent, surtout lorsqu'ils voient d'autres membres de ce groupe partager des informations erronées.

Heureusement, les gens ont aussi un tic comportemental qui peut les combattre: nous voulons être perçus comme honnêtes. La recherche a montré que l'incitation à mentir des gens diminue quand ils croient qu'il y a un risque plus élevé de conséquences négatives, sont rappelés à propos de l'éthique, ou commettre se comporter honnêtement.

Voilà pourquoi les codes d'honneur réduire la triche et promesses de virginité retarder début sexuel.

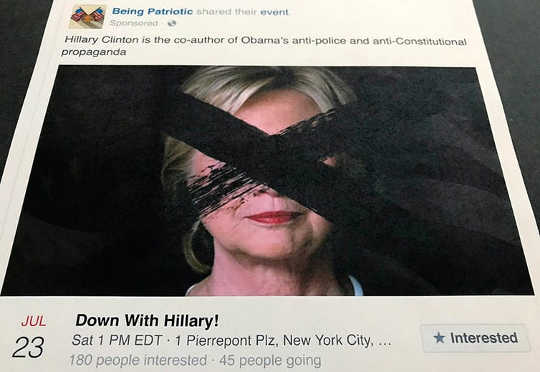

'Being Patriotic' était une page Facebook qui aurait été dirigée par des provocateurs russes essayant d'influencer les élections 2016. Mais cela n'aurait jamais été le cas si des utilisateurs réguliers ne l'avaient pas partagé. Photo AP / Jon Elswick

Prendre l'engagement

C'est là qu'intervient le "serment pro-vérité".

Consterné par la désinformation qui caractérise à la fois les élections américaines et Campagne britannique du Brexit, un groupe de scientifiques comportementaux de l'Ohio State University et de l'Université de Pennsylvanie, dont moi-même, voulaient créer un outil pour lutter contre la désinformation. L'engagement, lancé en Décembre 2016, est un projet d'un but non lucratif, j'ai cofondé appelé Insights intentionnels.

L'engagement vise à promouvoir l'honnêteté en demandant aux gens de s'engager à 12 comportements que les résultats de la recherche correspondent à une orientation vers la véracité. Par exemple, l'engagement demande aux preneurs de vérifier les informations avant de les partager, de citer des sources, de demander à des amis et à des ennemis de rétracter des informations qui sont fausses et de décourager les autres d'utiliser des sources d'informations non fiables.

Jusqu'à présent, environ 6,700 personnes et organisations ont pris l'engagement, y compris un psychologue social américain Jonathan Haidt, Philosophe moral australien Peter Singer, Bias des médias / vérification des faits et les législateurs américains Beto O'Rourke, Matt Cartwright et Marcia Fudge.

À propos de 10 mois après le lancement de l'engagement, mes collègues et moi voulions évaluer si en fait, il a été efficace pour changer le comportement et réduire la propagation des nouvelles non vérifiées. Nous avons donc mené deux études comparant le partage de promesses de dons sur Facebook. Pour ajouter un peu de perspective extérieure, nous avons inclus un chercheur de l'Université de Stuttgart qui n'a pas participé à la création de l'engagement.

In une étude, nous avons demandé aux participants de remplir un sondage évaluant à quel point leur partage de l'information sur leur propre et d'autres pages de profil correspondait aux comportements 12 décrits dans l'engagement un mois avant et après leur signature. L'enquête a révélé des changements de comportement importants et statistiquement significatifs, vérification plus approfondie des faitsun réticence croissante partager des messages chargés d'émotion, et un nouvelle tendance de repousser contre des amis qui ont partagé des informations.

Alors que l'auto-évaluation est une méthodologie bien acceptée qui imite l'approche des études sur codes d'honneur et promesses de virginité, il est soumis à la biais potentiel des sujets signalant des changements souhaitables - tels que des comportements plus véridiques - indépendamment du fait que ces changements sont présents.

Donc dans un deuxième étude nous avons obtenu la permission des participants pour observer leur partage Facebook réel. Nous avons examiné les premiers articles 10 pertinents un mois après avoir pris l'engagement et évalué la qualité de l'information partagée, y compris les liens, afin de déterminer à quel point leurs messages correspondaient aux comportements de la promesse. Nous avons ensuite regardé les premiers messages 10 pertinents 11 mois avant qu'ils ont pris l'engagement et évalué ceux-ci. Nous avons de nouveau constaté des changements importants et statistiquement significatifs dans le respect des comportements 12 par les preneurs, comme le nombre moins élevé de messages contenant de la désinformation et l'inclusion de plus de sources.

Clarifier la 'vérité'

La raison pour laquelle l'engagement fonctionne, je crois, est qu'il remplace le concept flou de «vérité», que les gens peuvent interpréter différemment, avec des comportements clairement observables, comme la vérification des faits avant le partage, la différenciation des faits et la citation des sources.

L'engagement que nous avons développé n'est qu'une partie d'un effort plus vaste visant à lutter contre la désinformation. En fin de compte, cela montre que des outils simples existent et peuvent être utilisés par Facebook et d'autres entreprises de médias sociaux pour lutter contre l'assaut de la désinformation des gens face à la ligne, sans recourir à la censure.

A propos de l'auteur

Gleb Tsipursky, professeur adjoint d'histoire de la science comportementale, The Ohio State University

Cet article a été publié initialement le The Conversation. Lis le article original.

Livres de cet auteur

at Marché InnerSelf et Amazon